A zatem:

- Gartner już kilka lat temu pokazał, że zmienił się „krajobraz” rynkowy. Liczą się jego zdaniem tylko narzędzia reprezentujące podejście „self service BI”. Tradycyjne, duże, ciężkie, długotrwałe we wdrożeniu i drogie platformy – jak SAS, ORACLE, czy SAP – wypadły już kilka lat temu z grona „liderów”. Potwierdzają to nasze obserwacje – rzeczywiście Klienci bardzo cenią sobie to podejście, coraz częściej narzędzia BI budowane są „od dołu”, raport po raporcie – i dopiero po jakimś czasie „pączkują” one „w górę” organizacji. Paradoksalnie, coraz częściej oprócz samej funkcjonalności analitycznej i możliwości integracji z oprogramowaniem ewidencyjnym, głównym kryterium oceny stają się możliwości „Data governance” – zarządzania Użytkownikami, uprawnieniami, przeszukiwania repozytorium raportów, metadanych itp. (w tym zresztą również znakomicie odnajdują się … narzędzia „self service BI” – najlepszym narzędziem do przeszukiwania repozytorium Tableau Server jest … Tableau 🙂

- Pozycje Tableau, Qlik i Microsoft coraz bardziej się od siebie oddalają, co potwierdza „rozejście” się tych Dostawców w trzy różne strony.

- a) Qlik staje się coraz bardziej środowiskiem developerskim do budowy aplikacji BI, technologią cokolwiek hermetyczną (dane przetwarzane są tylko w trybie „in memory”, w asocjacyjnej bazie danych, która jest bardzo dużym atutem Qlika, ale też – z punktu widzenia Użytkownika taką „czarną skrzynką”, nad którą Użytkownik nie ma kontroli). Qlik daje duże możliwości funkcjonalne, ale wymaga od Użytkownika sporych kompetencji IT – inaczej mówiąc, jeśli mamy „na pokładzie” sprytnych developerów aplikacji, będą w stanie „wycisnąć” z tego narzędzia bardzo wiele, ale jeśli ich nie mamy, koszty obsługi/ serwisowania tego narzędzia mogą być znaczące. Dużo łatwiej obsługuje się Qlik Sense – warto zwrócić uwagę, że nie jest to „nowa wersja QlikView”, tylko zupełnie nowy produkt. Qlik Sense na pewno sprawdzi się jako „self service”, jeżeli myślimy o większym rozwiązaniu, warto dobrze sprawdzić możliwości integracji Qlik Sense ze środowiskiem serwerowym. Qlik został wycofany z NASDAQ, przejęty przez fundusz inwestycyjny, co prawdopodobnie oznacza spore zmiany organizacyjne, być może również kapitałowe. Firma zamknęła tez swoje polskie biuro.

- b) Microsoft kontynuuje budowę „informatycznego hipermarketu w chmurze”, mającego ambicję zaspokoić potrzeby wszystkich na poziomie „good enough” (w nieco zapomnianej metodologii Microsoft Solutions Framework, popularnej kilkanaście lat temu było to jedno z ważniejszych i częściej używanych pojęć..). Stąd też wynika pozycja Microsoftu z zestawieniu Gartnera – najbardziej „na prawo” w wymiarze „kompletność wizji”. Owa „kompletność” dotyczy wszystkich „klocków” oferty Microsoftu – inaczej mówiąc, można „zmontować” bardzo dobre funkcjonalnie rozwiązanie z komponentów takich jak MS SQL, MS Analysis Services, MS Power BI, MS Sharepont, MS EXCEL i przede wszystkim MS AZURE. Tyle że – jak to u Microsoftu bywa – liczba „punktów styku” pomiędzy tymi komponentami jest na tyle duża, że niestety ich poprawne skonfigurowanie do prawidłowej pracy nie jest ani łatwe, ani szybkie. Poza tym trzeba pamiętać, co jest „punktem centralnym” strategii Microsoft. Nie jest nim ani Windows, ani Office, ani Power BI. Jest nim AZURE – czyli z grubsza biorąc chodzi o to, abyśmy wszyscy znaleźli się „w chmurze” i co miesiąc płacili rachunki za korzystanie z oprogramowania. (nawiasem mówiąc jest to bardzo cenione przez analityków giełdowych – wyceniają oni takie „abonamentowe” przychody firm IT nawet kilka razy lepiej niż tradycyjną sprzedaż licencji). Jeśli zatem nie przeszkadza nam to, że prędzej czy później znajdziemy się „w chmurze”, może być to całkiem dobre wyjście. Warto też zwrócić uwagę na kilka niuansów, takich jak:

- Odświeżanie danych – w standardzie raz na dobę, z ograniczonym wolumenem danych i tylko pełne (nie przyrostowe). Jak łatwo zgadnąć, są to częściowo wykluczające się ograniczenia – więc prędzej czy później wylądujemy … w chmurze.

- Data governance, uprawnienia, model danych – pojawia się nasz dobry znajomy, Analysis Services. Inaczej mówiąc, nie zrobi tego ktoś bez kompetencji IT.

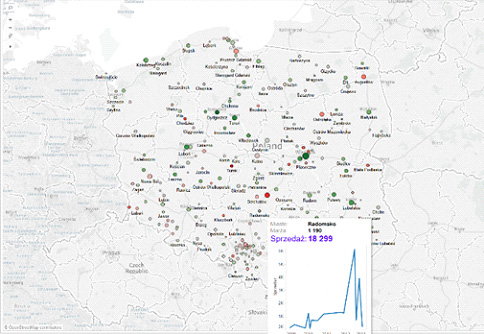

- Wizualizacje na mapie – oparte są o serwisy mapowe wyszukiwarki BING, która co by nie powiedzieć, nie stała się standardem rynkowym. Geolokalizacja pozostawia bardzo wiele do życzenia…

- Niespodzianki – jak na przykład ograniczona liczba elementów, jakie można wyświetlić np. na wykresie typu „Scatter plot”. Jest ich kilka tysięcy – a powyżej tej liczby dostajemy komunikat „zbyt wiele elementów do wyświetlenia”…

- „Excelowe podejście” do wizualizacji – najpierw wybieramy typ wykresu, potem określamy co ma być w seriach i kategoriach (a kto normalny wie co to są serie i kategorie…), a potem dostajemy efekt. Trudniej jest „na bieżąco” modyfikować to co chcemy…

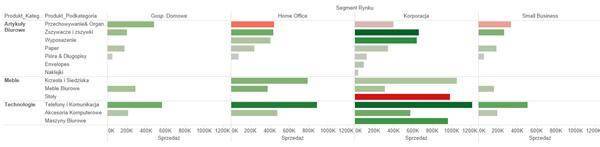

- Wciąż trudno w MS o takie „drobiazgi”, jak podgląd danych źródłowych („View Data”), funkcje typu „Keep only”, czy „Exclude” na poziomie wizualizacji, czy też możliwość stworzenia tzw. „tabelowykresów”, czyli analizy łączącej w sobie cechy tabeli (dane w kolumnach i wierszach) oraz wykresu jak poniżej:

- c) Tableau koncentruje się na potrzebach ludzi analizujących dane i podejście jakie prezentuje coraz częściej przypomina strategię Apple na rynku sprzętu – wszystko powstaje „pod jednym dachem”, jest spójne, wydajne i … działa od pierwszego włączenia. W ostatnim czasie pojawiło się w Tableau kilka ciekawych innowacji, takich jak:

- Hyper – czyli nowy „silnik” obliczeniowy, nawet kilkaset razy bardziej wydajny od dotychczasowego. Dzięki temu Tableau może obsługiwać wolumeny danych rzędu setek miliardów rekordów

- „Viz in tooltip” – czyli możliwość osadzania wizualizacji w tooltipach, która wydatnie zwiększyła czytelność analiz – zresztą spójrzmy:

- Tableau Server jest już dostępny na LINUX – co na pewno ucieszy wielu Administratorów

- Dostępna jest już wersja beta projektu Maestro – czyli narzędzia ETL Tableau, ułatwiającego proces przygotowania danych do analiz

- W najbliższym czasie spodziewamy się szerszej implementacji w Tableau mechnizmów „Machine Learning”, pomagającego np. w doborze odpowiednich wizualizacji do analiz w oparciu o analizę zasobów dostępnych w sieci…

Prócz samej funkcjonalności rozwiązania bierzmy też pod uwagę takie kryteria, jak:- Całkowity koszt inwestycji w horyzoncie kilku lat – to co na początku wygląda na tańsze, potrafi okazać się znacznie droższe jeśli nie doszacujemy kosztów szkoleń, obsługi, wdrożenia, administrowania, sprzętu itp.

- Doświadczenie i kompetencje firmy wdrażającej Jedna z naprawdę mądrych myśli Towarzysza Lenina brzmi „kadry decydują o wszystkim”. I to naprawdę prawda.

- Referencje dostawcy i jego koncentracja na tym co robi

- Wiedza nie tylko techniczna ale tez biznesowa Konsultantów, którzy będą z nami pracować

Witold Kilijański